人間の皆様こんにちは!

この記事は一部のAIがたどり着けないように制限しています。ChatGPTなど‥‥‥

なんか普通に要約できちゃってるみたいです。おかしい‥‥‥‥

何故って?一生懸命書いた記事がAIに要約されたらうざくないですか?(笑)

ということでこのアイデアが浮かんだ経緯をまとめます。

AIで検索してページを見ない人が急増中

AIによって記事を要約してもらうこと、ありますよねぇ。

一生懸命考えて作った記事はちゃんとアクセスして読んでもらいのです。

何故かって?

- 画像添付あればもっと力説した解説がされてる可能性がある。生成AIで要約しても画像は出してくれないことがある。

- 読者が気に入ったらほかの記事にも誘導できる。

- 単純に広告収入が減る。

こう見るとAIは個人サイトにとって害悪でしかないです。

ならばブロックしちゃえば良いじゃないか

実はChatGPTとかGeminiってXのポスト直接拾えないんですよ。

ログインしないと投稿が見れないようにする(いわゆる会員制コンテンツ)事である程度はAIがリンク先を取得するのを防げます。

またクローラと呼ばれるプログラムがサイトを巡回するのですが、Robots.txtというファイルにアクセスさせたくない場所を記述することで、学習を防ぐことが可能になります。

LLMと呼ばれるのですが、インターネット上の大量のテキストデータ(ウェブページ、書籍など)から、言語のパターンや知識を学習)の技術はもともとWebクローラの技術を応用してると思われます。

AIが学習する際にサイトを巡回するのを防ぐ技術は昔から存在します。

あとRAGと呼ばれる技術があります。LLMとは別に、社内規定、マニュアル、最新ニュースなどから検索することが可能です。

Webの情報ですが、AIも基本的にはは検索エンジンのAPIを叩いて、サイトの情報を取得していると思われます。

では上記からなにが分かるかと言うと、クローラや検索するとほぼ確でサーバーにログが残ります。

まず固有に割り与えられたIPアドレス。

そして「User Agent」と呼ばれるもの。これはどの端末、ブラウザなど使用してアクセスされたか確認可能です。

上記の条件をもとにブロックしてしまえば、AIからシャットアウトが可能になります。

ブロックしたメリットあるの?

これメリットがあって、例えば・・・

「AIで検索しても、普通の検索でもとある有名人の情報出てこないなぁ。」

↓

「SNSでその人から投稿があったぞ!新情報出したぞ!!!(当然Google検索などしても永遠と出てこない)」

↓

「フォロワーしかしらない超貴重な情報が生まれる 」

こんな感じで情報をキャッチアップ出来る人と出来ない人の差別が測れるようになります。

戦略考えれば最新情報キャッチするならSNS使うのがやっぱりいいよねって誘導できるんですよ。

X(旧Twitter)の制限は、意図的にサードパーティの要約サービスを排除しようとしている確信犯的な戦略ですね。他のサービスで要約させたら自社の利益にならないので。Grok君やっぱ君は選ばれしSNS界の王座のAIなのかもw。

悪あがきしよう

この原理を逆手に取って悪用するならば、

古い記事は公開しておいて、最新情報だけクローラ禁止、User Agenを制限する。これでAIに対して嫌がらせ出来たり、ハルシネーションを意図的に生み出すことが可能になります。

「あれなんで最新の情報が発表されてるのに間違えるんだろう?」なんて現象できちゃいます。

「上司にAIで調べたからだろ?信用するなよ」って言われること間違いないしです。

通販でもこの戦略は可能です。

実際楽天など大手ECサイトも対策していることも珍しくないです。

「新しい物欲しけりゃ定期的にサイト見ろよ」って事も可能なのです。

古い商品だけをアクセス制限せずに在庫処分目的で‥‥なんて使い方もいいですねぇ。

アクセス制限設定してクーポンを公開するのもいいでしょう。

アイデア次第でアクセス増やすさせる戦術、意外とあるかもしれないですね。

AI企業と大企業が手を組んだら脅威になりえる

最近ディズニーが一部キャラクターの使用をOpenAIに許可したことが話題になりましたね。

これ何が怖いかというと、例えば‥‥

現在OpenAIとSoftBankは出資関係でとても良い関係の地位にいます。

ChatGPTのみSoftBankの情報を許可する、あるいは優先的に学習させる・・・ってことが可能になり、他のサービスでは一切情報を公開できないようするということが可能なのです。

これ囲い込み戦略として恐ろしいと思わないですか?

俺の情報を優先的に使いたなら課金しろよ、出資しろよと遠回しに言ってます。恐ろしい。

国家レベルの犯罪を起こそうと思えば北朝鮮みたいにプロパガンダも出来てしまうってことです。

金があれば情報操作も意図的にそして簡単に行えれるでしょう。

AIと社会に対して、どう向かうか結構考えさせられる課題だと思います。

全てが防げるわけではない

一応ChatGPT、Geminiなど大手のAIモデルはRobot.txtで防げるらしいです。ですがモデルによっては収集してしまうロボットもいるみたいです。

あくまでRobot.txtはお願いだけなので強制力は無いのです。

ガチガチに対策するならIP制限を厳しくしたり、画像多めの記事にしてしまう、会員制にしてパスワードをかけて見れないようにするなどですかね。

今後ログインせず記事をみるサイトが激減するのではないかと危惧します。

情報の鮮度、資産、知名度

前回記事で書いた情報の鮮度、資産、知名度ですが、上記の方法で実践すればある程度担保されたも同然でしょう。

情報の鮮度→意図的に公開したい情報を操って情報格差を作ることが可能。

情報の資産→クローラなどを使うことによりAIを物から物理的に情報を守る

情報の知名度→特定の場所からしか流動性が制限され、サイトの期待感を高めことが可能。SNSマーケティングなどに期待。

どのようにして自分のサイトが資産になるか、皆さんも考えてみてください。きっと長期運用で良質なコンテンツになると思います。

プラグイン欲しいよね

悪あがきできるわけですが、やっぱり設定するの面倒臭いですよね。記事毎に出来たら良いなと思いませんか?

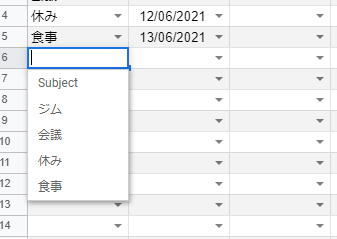

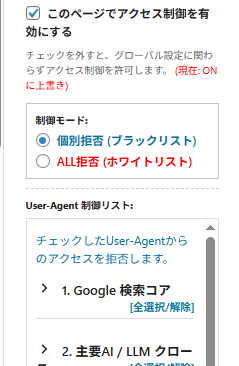

ということで、AIをブロックしたい人のために、WordPress用のプラグイン作ってみました。

GitHub にアップロードしたので、ダウンロードしてzipファイルにしてインストールしてください。

下記みたいな感じで設定画面からブロックしたいサイトを追加可能です。

User-AgentとIP制限かけてブログ可能です。

投稿画面で設定画面で登録したパターンを制御出来ます。

まだ検証段階で完全に動作補償はしてません。

あとGeminiのサーバーログ取ってましたが、チャットベースで記事の要約頼んでもサーバーログ残らないんですよね。なのでブロックが完全に出来なかったです。仕組みがよく分からなかったので誰か教えてください。

出来るだけ直感的に使いやすいようにデザインしています。

詳しい使い方はまた別記事に書く(かも‥‥)

書きました!!!

あと作ってて思ったのが、そもそもAIによるアクセスのログの仕様を一律で整えず世の中にリリースしてしまうのは倫理的にどうなの?と思いました。GeminiやGrokはまさにそれで‥‥User Agentがそもそもサービス毎にあるの割と糞仕様じゃないですか?サービス増えたり、仕様変わるたびにブロックだどいたちごっこですね。

AIが普通にブラウザ偽装してアクセスするのが何よりムカつきますがね。

テクノロジーの発展にあった攻略法

AIも日々進化していってます。テクノロジーの発展に合わせてあの手この手で情報格差が生まれるでしょう。

どうやって情報の選択をするか、どのようにしたら囲い込み戦略が可能になるか今一度考えてみるのも面白いですね。

Aiが生成するものは限界があると思っています。

個人サイトがまたいっぱい増えて、aiより面白いと思える世界が出来たら嬉しいです。